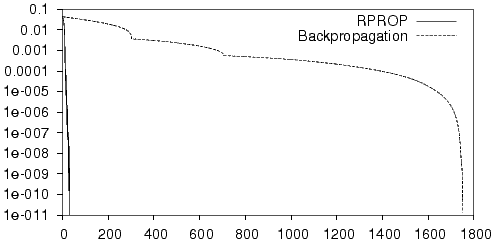

12.2. Vergleich verschiedener NetzarchitekturenUm die Leistungsfähigkeit des fuzzy-logischen-Netzes bezüglich des Lernerfolgs und der Generalisierung einzuschätzen, wurde ein Vergleich mit zwei anderen Netzarchitekturen vorgenommen; einem linearen Netz und einem Multi-Layer-Perceptron. Dazu wurden die verschiedenen Netze mit denselben Trainings- und Testmengen trainiert und die Ergebnisse des Trainingsprozesses verglichen. Bei dem fuzzy-logischen Netz wurde als Netzeingabefunktion die dem jeweiligen Operator zugeordnete Auswertungsfunktion verwendet. Dafür wurde der q-Operator benutzt und als Aktivierungsfunktion die semilineare Funktion. Die Struktur ist durch die in Kapitel 9 beschriebenen fuzzy-logischen Regeln gegeben, die Netzstruktur wurde in Abbildung 9.6 dargestellt. Da das fuzzy-logische neuronale Netz in der beschriebenen Form aus bis zu sechs Schichten besteht, ist es mit Standard-Backpropagation kaum noch zu trainieren. Mit RPROP gelingt dies zwar besser, aber eine Reduktion der Netztiefe erscheint immer noch sinnvoll. Daher wurde ein reduziertes fuzzy-logisches Netz ebenfalls getestet. Hier wurden alle verschachtelten logischen Konnektive gleicher Art zusammengefaßt. Die sich daraus ergebende Struktur wird in Abbildung 12.2 dargestellt. Dabei ist zu beachten, daß bei diesem Netz keine Verbindung mehr von den Neuronen CInputConstDist und CInputConstLen zum Ausgabeneuron CInputSegment besteht. Daher eignet es sich für reine Segmentierungsaufgaben weniger. Solche Versuche wurden aber mit diesem Netz nicht durchgeführt. Man könnte ggf. entweder wieder zusätzliche Neuronen einfügen oder einen Weight-Sharing Mechanismus einführen, der dafür sorgt, daß die gelernten Gewichte von CInputConstLen nach CItrQual auch für die Verbindung nach CInputSegment verwendet werden. Zusätzlich wurde versuchsweise das reduzierte FLN mit Bias-Verbindungen aller Neuronen versehen. Es ist allerdings nicht klar, wie ein solcher Bias fuzzy-logisch zu interpretieren wäre. Da der Bias der Ausgabeneuronen vor allem der Anpassung an den absoluten Wert |